N’est-il pas temps de repenser sa stratégie de sauvegarde ?

Une copie de sauvegarde étanche : une obligation vis-à-vis des cyber-attaques

Depuis plusieurs années, tous les experts en cybersécurité insistent sur le fait de disposer d’une copie étanche des données sous forme de sauvegarde du SI.

Quelle que soit la technologie utilisée, cette stratégie de cyber-résilience doit empêcher qu’une cyber-attaque sophistiquée (prise de contrôle de l’AD, élévation de privilèges sur les serveurs, …) permette aux cyber-attaquants de corrompre ou de détruire cette copie de sauvegarde étanche.

Il existe plusieurs approches technologiques pour gérer cette étanchéité :

- Stockage immuable (certains parlent d’immutable) pendant une durée paramétrable (au minimum une durée de rétention d’une semaine).

- Isolation réseau complète des sauvegardes.

- Interdiction d’accès au stockage externalisé.

- Stockage sur bande/cartouche ou sur un NAS déconnecté.

Attention cependant aux efforts de maintenance à fournir suivant le procédé choisi.

Quelques soient les technologies utilisées, on voit que globalement, les entreprises ont compris l’enjeu de se protéger via ce dernier niveau de sauvegarde.

Pourquoi continuer à garder en local des durées de rétention longues ?

Historiquement, les politiques de sauvegarde des Clients ressemblaient peu ou prou à cela :

- 30 derniers jours

- 4 dernières semaines

- 12 dernier mois

- 3 dernières années

Naturellement, cette sauvegarde se faisait en local : soit sur des appliances spécialisées, soit des espaces de stockage NAS ou SAN ou soit via des bandes/cartouches.

Pourquoi continuer à garder en local alors que la sauvegarde locale génère de nombreuses contraintes (financières, qualité, …) ?

Pour certaines très bonnes raisons :

- Pour les clients ayant des gros volumes de données (100 To ou plus), il existe des appliances/solutions de sauvegarde locales extrêmement efficaces en déduplication à la cible qui permettent des taux de déduplication de 90, voire 95 %.

- Pour les plus petits clients (quelques To), des solutions bon marché de serveur NAS avec une évolution de tailles des disques durs qui rendent le coût au To imbattable (un disque dur de 20 To ne coûte que 500 €).

- Et surtout des coûts des réseaux WAN (internet, SD WAN ou évidemment MPLS) qui sont importants et qui limitent les options de sauvegarde distantes.

Mais pour la majorité des entreprises ou organismes, cela reste-t-il toujours pertinent ?

D’un point de vue usage, quel sont les besoins de délai de restauration ?

Si on analyse les besoins en termes de délai de restauration, on se rend compte que les restauration urgentes sont exclusivement des besoins de restauration sur des données récentes (le plus souvent du dernier état de la sauvegarde réalisée), telles que :

- Restauration d’un répertoire bureautique effacé par mégarde par un utilisateur.

- Restauration d’une base de données corrompue par un traitement.

- Restauration d’une VM complète suite à une panne d’hyperviseur, etc…

Dans ces différents cas, il faut privilégier la vitesse de restauration des données. Les mécanismes de sauvegarde en local et de restauration locale sont évidemment pertinents car le débit du LAN ne constitue pas un goulot d’étranglement.

Dans un contexte de sauvegarde dans un Cloud (ou Datacenter externalisé), la durée de restauration d’une sauvegarde externalisée sera toujours limitée par le débit du réseau WAN.

Il reste donc toujours pertinent de garder en local une profondeur de sauvegarde des 7 derniers jours par exemple.

En revanche, les besoins de restauration d’une version de base de données qui date de plusieurs semaines, ou d’un ensemble de fichiers datant de 12 mois sont rares, voire extrêmement rares (et sont souvent pour répondre à des besoins d’ordres réglementaires ou métier).

Alors les besoins de délais de restauration ne sont jamais immédiats et il est possible d’accepter une durée de 8 ou 24 heures pour restaurer ces données.

Dans ce contexte, il n’est généralement pas nécessaire d’avoir une grande profondeur de sauvegarde en local pour couvrir les besoins des métiers.

D’un point de vue besoin métier, disposer de durées de rétention longues en local est très souvent inutile.

En synthèse

Dans un contexte d’augmentation des données difficile à contenir et qui a un impact direct sur les besoins d’espace de sauvegarde local (et les coûts liés), il devient indispensable de repenser sa politique de sauvegarde.

La stratégie de sauvegarde qui consiste à conserver en local de longues durées de rétention semble perdre sa pertinence suivant l’évolution du contexte de la sauvegarde.

D’autant plus que d’avoir des sauvegardes anciennes dont on ne teste jamais la restauration, donne un niveau de garantie faible sur la capacité à pouvoir les restaurer un jour !

Utiliser les technologies Cloud pour conserver les rétentions longues des sauvegardes offre de nombreux atouts :

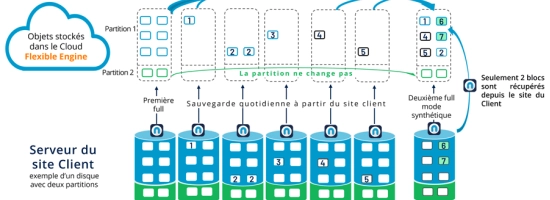

- Possibilité d’utiliser des classes de stockage optimisée (tiering) en fonction des périodes de rétention, comme par exemple :

- Stockage chaud : pour les 2 premières semaines (répliqué sur plusieurs DC)

- Stockage tiède : entre 2 semaines et 12 mois (2 à 3 fois moins cher que le stockage chaud)

- Stockage froid : au-delà de 12 mois (plus une vision d’archivage que de sauvegarde)

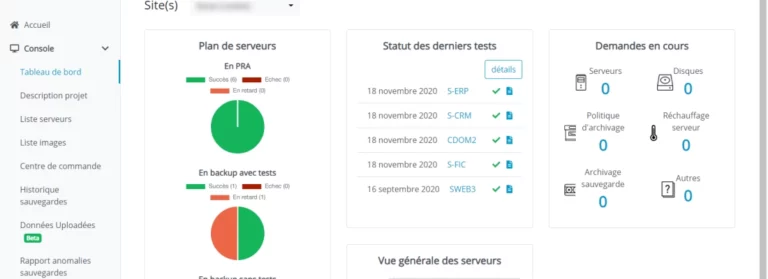

- Possibilité de mettre en place de façon automatique des tests de redémarrage de serveurs ou de restauration de données

- Scalabilité du stockage : plus de souci de gestion de la capacité de l’espace de sauvegarde, celui-ci étant quasi infini

- Possibilité de répliquer les sauvegardes entre plusieurs régions (pays) , etc ….

Si chaque contexte d’entreprise est différent, il semble pertinent au moins de se poser la question : N’est-il pas temps de repenser ma stratégie de sauvegarde ?

Dans un prochain article, nous analyserons les nouveaux critères à intégrer dans une politique de sauvegarde.